Ma quanto riempie la bocca la parola “Miliardi”? Anche “Milioni” non scherza, ma Miliardi…

É la rivincita di Elon Musk: #xAI, la startup di intelligenza artificiale proprio del magnate di Tesla (o del folle dell’ex Twitter, come preferisci), ha recentemente annunciato un nuovo round di finanziamento da 6 miliardi di dollari, portando la valutazione della società a un valore compreso tra i 18 e i 24 miliardi di dollari (Fonte: https://x.ai/blog/series-b)

Questo finanziamento segna una rivincita per Musk, che ha una storia complicata con l’#AI generativa risalente a quando co-fondò #OpenAI con Sam Altman circa dieci anni fa. OpenAI, originariamente una no profit, è diventata poi una società a scopo di lucro e ha sviluppato ChatGPT, collaborando strettamente con Microsoft, un cambiamento che Musk ha vissuto come un tradimento.

xAI, lanciata da Musk come sfida a questo scenario, utilizzerà i fondi per lanciare i suoi primi prodotti sul mercato, costruire infrastrutture avanzate e accelerare la ricerca e sviluppo di nuove tecnologie. Tra gli investitori figurano nomi importanti come Andreessen Horowitz e Sequoia Capital. Musk ha annunciato che ci saranno ulteriori comunicazioni nelle prossime settimane, perché si sa, l’attesa è la madre di tutte le speculazioni finanziarie.

Precedentemente, Musk ha introdotto #Grok, un rivale di ChatGPT integrato nella piattaforma X.com, che però non ha ottenuto risultati eccezionali. xAI, guidata da dirigenti con esperienze in aziende come DeepMind, Microsoft e Tesla, ora mira a competere con i leader del mercato come OpenAI e Google, sostenuti rispettivamente da Microsoft e dai loro prodotti di punta come ChatGPT e Google Gemini. In pratica, è una lotta tra titani, dove ogni mossa è seguita da un coro di “vediamo se questa volta ce la fanno”. Soprattutto da parte di quelli che hanno messo sul tavolo 6 miliardi.

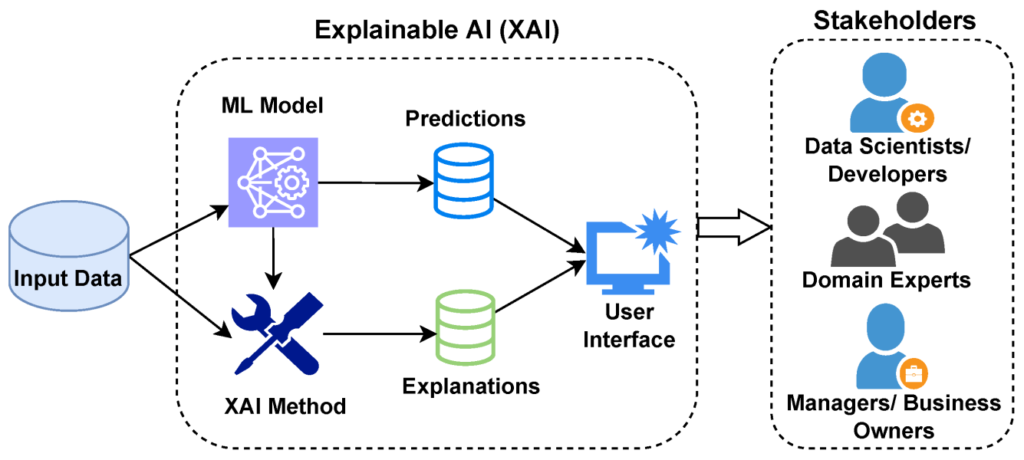

Nota: quella “x” prima di “AI” non è un vezzo ma sta per “Explainable”. E quindi, in soldoni, l’intelligenza artificiale spiegabile (XAI) è un’intelligenza artificiale (AI) programmata per descrivere il proprio scopo, la logica e il processo decisionale in un modo che possa essere compreso dalla persona media. XAI aiuta gli utenti umani a comprendere il ragionamento alla base degli algoritmi di intelligenza artificiale e machine learning (ML) per aumentare la loro fiducia.

L’intelligenza artificiale spiegabile è spesso discussa in relazione al deep learning e svolge un ruolo importante nel modello ML FAT – fairness (equità), accountability (responsabilità) e transparency (trasparenza). La XAI è utile per le organizzazioni che vogliono costruire fiducia nell’implementazione di una AI.

La XAI può aiutarle a comprendere il comportamento di un modello di AI, aiutando a trovare potenziali problemi come i bias dell’AI. I modelli di ML sono tipicamente strutturati in formato white box o black box. I modelli white box offrono maggiore visibilità e risultati comprensibili agli utenti e agli sviluppatori, mentre le decisioni o le previsioni dell’AI fatte dai modelli black box sono estremamente difficili da spiegare, anche per gli sviluppatori di AI.

La XAI fornisce dati generali su come un programma di AI prende una decisione divulgando quanto segue:

a) I punti di forza e di debolezza del programma.

b) I criteri specifici che il programma utilizza per arrivare a una decisione.

c) Perché un programma prende una decisione particolare rispetto ad alternative.

d) Il livello di fiducia appropriato per vari tipi di decisioni.

e) Quali tipi di errori il programma tende a commettere.

f) Come possono essere corretti gli errori.

Importanza dell’AI spiegabile:

a) Un obiettivo importante della XAI è fornire responsabilità algoritmica. I sistemi di AI erano prevalentemente black box. Anche se gli input e gli output sono noti, gli algoritmi utilizzati per arrivare a una decisione sono spesso proprietari o non facilmente comprensibili.

b) Con i servizi di AI integrati in settori come la sanità IT o la concessione di mutui, è importante garantire che le decisioni prese dai sistemi di AI siano solide e affidabili. Ad esempio, a causa di un bias dell’AI, un individuo potrebbe vedersi negato un mutuo.

Esempi di intelligenza artificiale spiegabile:

La XAI può essere trovata nei seguenti settori: a) Sanità: i sistemi di intelligenza artificiale spiegabili che aiutano nella diagnosi dei pazienti possono contribuire a costruire fiducia tra il medico e il sistema, poiché il medico può comprendere dove e come il sistema di IA raggiunge una diagnosi.

b) Finanziario: la XAI è utilizzata per approvare o negare richieste finanziarie come prestiti o mutui, nonché per rilevare frodi finanziarie.

c) Militare: i sistemi militari basati su AI devono essere spiegabili per costruire fiducia tra il personale di servizio e qualsiasi attrezzatura abilitata all’AI su cui fanno affidamento per la sicurezza.

d) Veicoli autonomi: la XAI è utilizzata nei veicoli autonomi per spiegare le decisioni basate sulla guida, soprattutto quelle che riguardano la sicurezza. Se un passeggero può comprendere come e perché il veicolo prende le sue decisioni di guida, può sentirsi più sicuro sapendo quali scenari il veicolo può o non può gestire bene.

La XAI presenta anche le seguenti limitazioni:

a) Spiegabilità rispetto ad altri metodi di trasparenza. Un sistema XAI potrebbe semplificare eccessivamente e rappresentare in modo errato un sistema complesso, portando a un dibattito sulla progettazione di sistemi di AI con modelli più interpretabili o modelli che possono associare più accuratamente cause ed effetti.

b) Prestazioni del modello. I sistemi XAI tipicamente hanno prestazioni inferiori rispetto ai modelli black box.

c) Difficoltà di addestramento. Creare un sistema di AI che spieghi anche il suo ragionamento è più complicato rispetto ai modelli black box.

d) Privacy. Se un sistema XAI lavora con dati riservati, tali dati potrebbero essere esposti a causa della natura trasparente della XAI. Concetti di comprensione e fiducia. Sebbene la XAI dovrebbe portare a un aumento della fiducia nell’AI, alcuni utenti potrebbero comunque non fidarsi del sistema, anche con una spiegazione comprensibile dietro le sue decisioni.

Vantaggi: Il principale vantaggio dei grafici ICE (Individual Conditional Expectation) è che consentono di catturare relazioni eterogenee, cosa impossibile da fare osservando solo i PDP (Partial Dependence Plots).

Svantaggi:

a) La caratteristica di interesse non dovrebbe essere correlata con le altre caratteristiche.

b) Difficili da comprendere se troppi grafici ICE sono presenti in un unico quadro.